可解釋性是可信AI的核心特征

人腦的決策通常是一個邏輯和推理的過程,技術(shù)的使用者會同樣希望人工智能模型能具備一定的透明度,能夠描述、監(jiān)督、重現(xiàn)分析和決策的邏輯和判斷過程,以及使用和創(chuàng)立的數(shù)據(jù)來源、動態(tài)變化等。易觀分析認為,判斷一個人工智能是否可信,包含了被解釋、被理解、被信任三個層次的內(nèi)涵。可解釋性是可信的基礎(chǔ),也是公平性、普惠性、可追溯性等特征的前提;相應(yīng)地,不可解釋的AI會帶來不同程度的風(fēng)險和倫理問題。例如,算法歧視相較人為因素更不易察覺,可能會放大公平性偏差,不利于金融的普惠化;機器學(xué)習(xí)在金融領(lǐng)域的試錯成本很高,決策的錯誤可能會引發(fā)嚴重的信用風(fēng)險,造成銀行損失。

一個可解釋的AI是可以在數(shù)據(jù)點和決策點進行人為復(fù)盤和驗證的,確保AI做出的決策容易理解,才能放心地使用AI進行銀行業(yè)務(wù)活動,發(fā)揮降本增效的作用。在客戶評級、信用風(fēng)險預(yù)測、反欺詐、反洗錢、客戶畫像等銀行典型場景中,AI模型的可解釋性顯得尤為重要。

根據(jù)業(yè)務(wù)的風(fēng)險要求來平衡AI的可解釋性和性能

如今,深度神經(jīng)網(wǎng)絡(luò)正在向著更準確、更智能的方向發(fā)展,然而算法的精確度和黑盒度也是此消彼長的,越是復(fù)雜和精確的模型,解釋和理解的難度就越高。模型從黑盒到灰盒再到白盒的過程中,模型的透明度提升,但這并非最終的目的,解釋的易理解性、準確性、合理性、一致性、實用性才是關(guān)鍵,更確切地說技術(shù)使用者需要評估AI的解釋力。從銀行業(yè)的視角來看,在安全可控的前提下充分發(fā)揮人工智能價值,需要根據(jù)不同業(yè)務(wù)場景下風(fēng)險敏感程度、風(fēng)控要求、精準性要求的不同,在可解釋性與性能之間進行權(quán)衡和相應(yīng)側(cè)重,結(jié)合專家經(jīng)驗來提升決策的解析度,逐漸增加人機之間的理解與信任。

綜合應(yīng)用可解釋方法幫助業(yè)務(wù)人員理解和評估

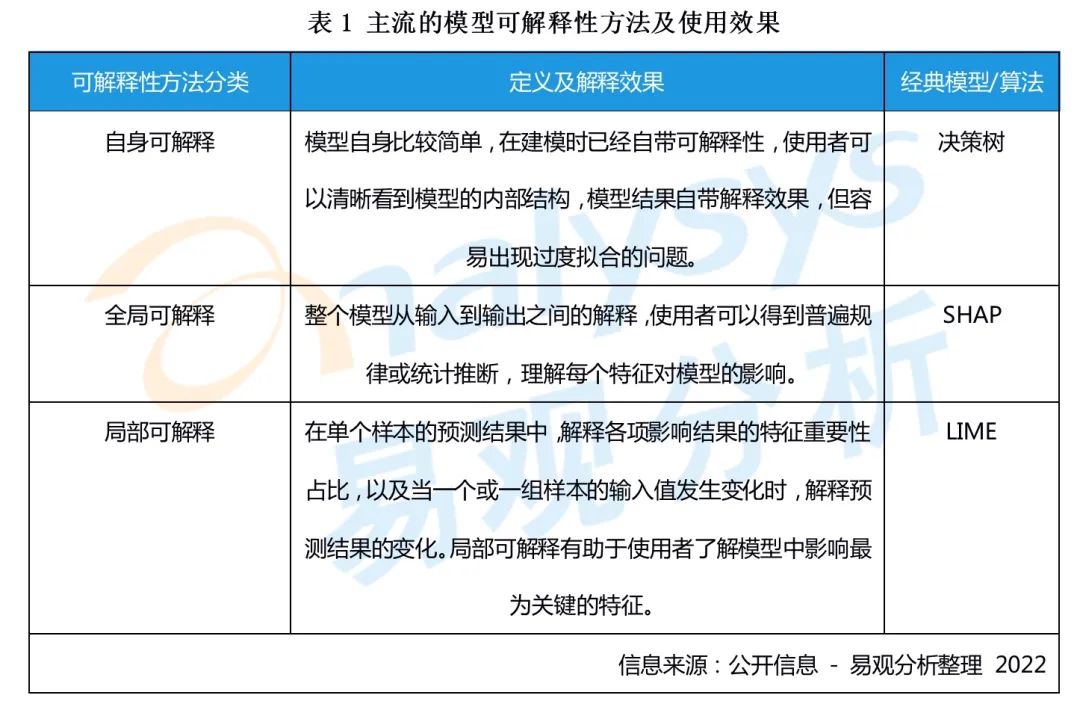

在機器學(xué)習(xí)領(lǐng)域,目前主流的可解釋性方法包括自身可解釋、全局可解釋、局部可解釋等,如下表所示:

銀行可結(jié)合業(yè)務(wù)需要進行綜合使用,以可視化平臺的方式來展現(xiàn)不同樣本的預(yù)測結(jié)果、決策因子和評判標準等,便于在事前或事后理解特征如何影響變量,或是單個樣本中的決策邏輯,從而更好地調(diào)整業(yè)務(wù)策略和風(fēng)險考量。

例如:客戶在線上貸款的申請被拒絕后,銀行業(yè)務(wù)人員可以通過局部可解釋性看出導(dǎo)致客戶未達標的關(guān)鍵因素;或是通過全局可解釋性,為業(yè)務(wù)部門提供整體性的貸款指標定性要求及重要性占比,使業(yè)務(wù)人員理解哪些特征對提高客戶貸款的成功率更重要,協(xié)助銀行進行精細化的客群經(jīng)營,提升貸款通過率的同時保證銀行風(fēng)控要求和客戶體驗。

給銀行的兩個建議

1.針對不同的應(yīng)用場景設(shè)定不同的解釋程度和驗證優(yōu)先級

人工智能可解釋性方法的研究目前還處于探索階段,也尚未形成通用標準的衡量體系,銀行業(yè)務(wù)部門在評估AI的可解釋性和性能時,可對不同場景設(shè)定相應(yīng)的透明度、準確度的等級要求。在進行小規(guī)模驗證時,可優(yōu)先從客戶評級、反洗錢、反欺詐等風(fēng)險敏感、可解釋必要性最高的場景進行驗證,其次考慮智能客服等交互場景,再考慮智能推薦等營銷場景。

2.以機器學(xué)習(xí)+專家經(jīng)驗交互協(xié)同的模式優(yōu)化決策模型

可解釋是為了使模型變得容易理解,并幫助業(yè)務(wù)提升和風(fēng)險防控。因此在使用中需要融入銀行業(yè)務(wù)專家的經(jīng)驗,使專家能夠理解并對AI決策的邏輯進行解析,來控制模型和算法風(fēng)險,并將業(yè)務(wù)經(jīng)驗反哺到模型中;同時,機器在深度學(xué)習(xí)和自我優(yōu)化中,也需要業(yè)務(wù)專家對特征影響分布的變化、引入新因子帶來的決策變化等進行及時評估,在和機器的不斷交互和相互理解中提高人機協(xié)同的效果。

更多閱讀推薦:

》》銀行需要明確低代碼與無代碼開發(fā)平臺的差異,以便于在技術(shù)規(guī)劃及產(chǎn)品選型上降低試錯成本

》》《數(shù)字經(jīng)濟全景白皮書》銀行數(shù)字化篇 重磅發(fā)布!

》》銀行業(yè)RPA趨向主動觸發(fā)流程,補足營銷場景執(zhí)行末端的渠道協(xié)同能力

微信掃描下方二維碼,每日推送更多有趣的數(shù)據(jù)&有料的報告,記得點贊哦!